Apple设备将禁止用户发送色情或裸露图片!?

Apple设备将禁止用户发送色情或裸露图片!?

近几年来,儿童色情问题日益严重,尤其是在网上更是广为流传,各大科技巨擎都纷纷出招打击,包括了Apple苹果。

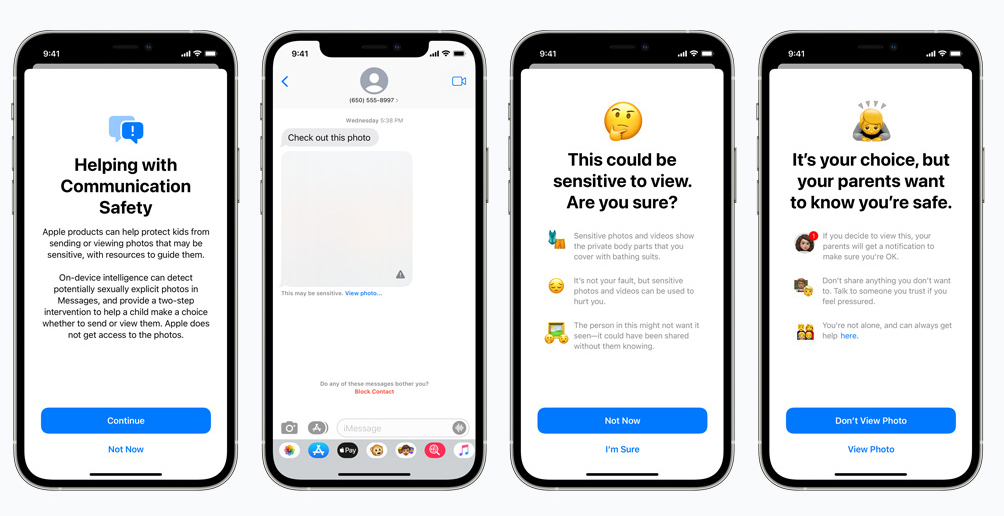

Apple今天宣布,他们将在Message (iMessage) 和iCloud 应用程序中引入色情图像检测功能,以打击儿童性虐待 (CSAM) 内容的传播。

这个系统是基于Machine Learning机器学习的AI系统构建的,将支持iOS 15、iPadOS 15 和macOS Monterey。

这个系统可以通过AI学习分析图像,以确保Message里提供给儿童用户的内容不涉及色情。

如果发现疑似是潜在色情的内容,儿童的父母的设备也将收到通知。

此外,出现在这些平台里的图像将由AI扫描,对比已报告给美国国家失踪和受虐儿童中心 (NCMEC) 的儿童性虐待图像。

当在用户的设备和他们的iCloud上找到与NCMEC数据库匹配的图像时,将会联系当局。

根据苹果的说法,由于数据库完善,这个机器学习系统可靠性极高,每万亿用户只会发生一次错误。

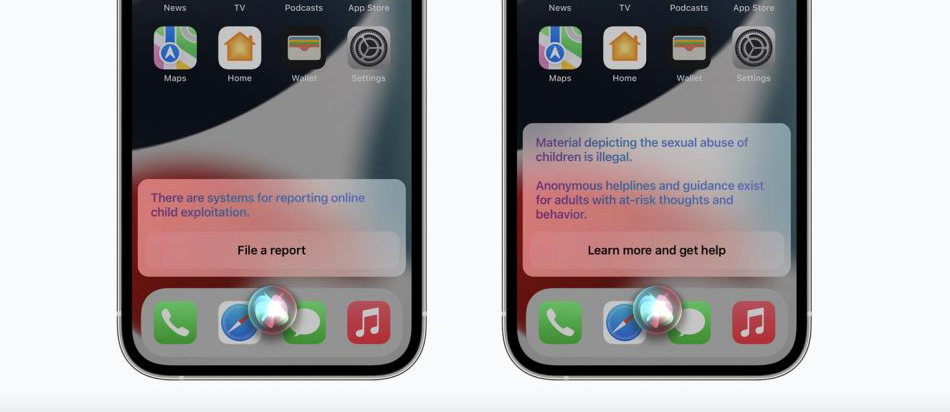

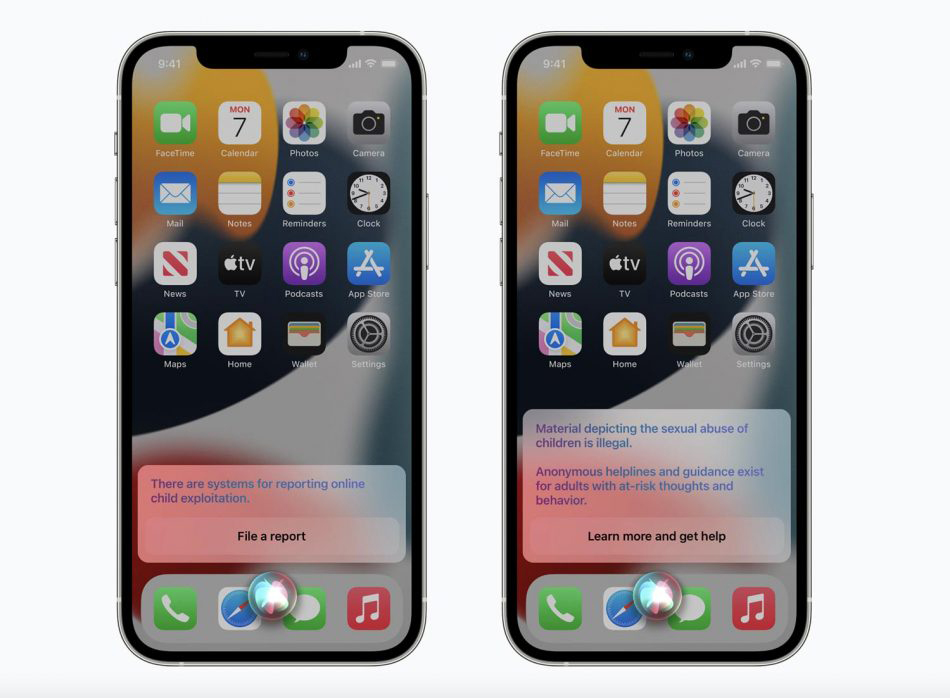

最后,如果Appl 设备用户通过 Siri 和 Search 进行搜索这类内容而被发现,他们会收到非法搜索内容的警告,并提供有关如何获得帮助以治疗这种不自然的性欲的建议。

目前,上述所有功能将仅首先提供给美国 iOS 15、iPadOS 15 和 macOS Monterey 设备的用户。

苹果坚称用户隐私仍然受到保护,因为整个检测和搜索是在苹果无法访问的设备中完成的。

更多消息请守住Mdroid。

来源:Amanz