Meta 开源人工智能模型AI ImageBind,可生成多感官内容

Meta 开源人工智能模型AI ImageBind,可生成多感官内容

Facebook 母公司 Meta 旗下的AI 部门近日正式发布了旗下的开源 AI 人工智能模式 ImageBind!

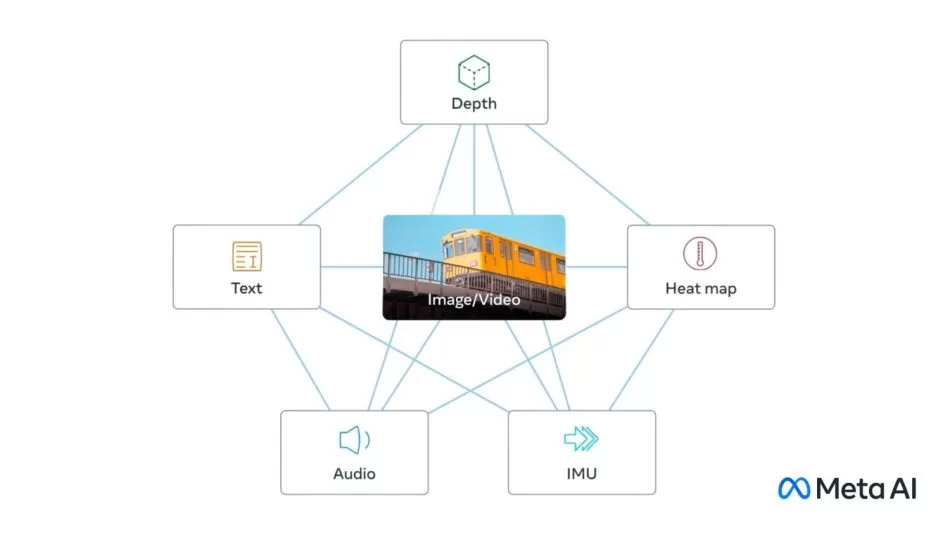

根据介绍,它是一种 Multimodal 多模态 AI 模型,能够同时处理六种不同的数据类型,包括图像、视频、音频、文本、深度、热度和惯性测量单元(IMU)。

多模态 AI 模型是指能够结合多种数据类型的 AI 模型,它们可以在不同的感官之间建立联系,从而实现更丰富和更自然的人机交互。

例如,AI图像生成器如DALL-E、Stable Diffusion 和 Midjourney 都是基于多模态 AI 模型的,它们可以根据用户输入的文本生成相应的图片。

ImageBind 是目前第一个能够将六种数据类型绑定在一个单一的嵌入空间的AI模型,它不需要显式的监督,也就是说,它不需要人为地给出每种数据类型之间的对应关系,而是通过自我学习来发现它们之间的内在联系。

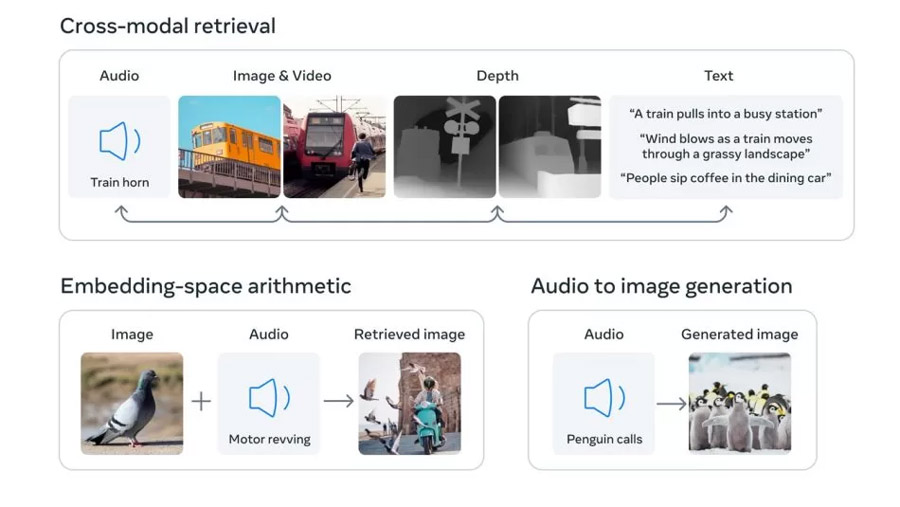

ImageBind 的嵌入空间是一个高维的数学空间,其中每个点都代表了一种或多种数据类型的信息。ImageBind 可以将任何一种或多种数据类型的输入映射到这个空间中,并在空间中进行各种操作,如搜索、比较、组合和生成。

ImageBind 还可以升级现有的 AI 模型,使其支持来自任何六种模态之一的输入。这意味着,用户可以用音频来搜索图片,用文本来生成视频,用深度信息来修改热度图像等等。

ImageBind 在跨模态的零样本和少样本识别任务上达到了新的最佳性能,甚至超过了之前专门针对这些模态训练的模型。

零样本和少样本识别任务是指让 AI 模型识别没有见过或只见过很少次数的数据类型或类别。例如,让一个只见过猫和狗图片的AI模型识别出老虎或狮子。ImageBind可以利用它在不同模态之间建立的联系来完成这样的任务。

Meta AI已经将ImageBind开源,并提供了一个在线演示,让用户可以体验 ImageBind 在图像、音频和文本模态上的能力。

用户可以上传自己的图片、音频或文本,并看到ImageBind如何将它们映射到嵌入空间中,并进行跨模态搜索、算术和生成等操作。

Meta AI表示,ImageBind是一个研究项目,目前还没有直接的消费者或实际应用,但它展示了未来AI系统可能具备的创造多感官体验的潜力,并表明Meta AI仍然愿意分享AI研究成果,在这个领域保持开放和透明。

有兴趣了解更多的童鞋们可以浏览 Meta ImageBind 展示网站:点我

更多消息请守住 Mdroid。

来源:Meta